栏目分类

热点资讯

成人校园春色 IBM POWER10:玄虚效才气压ICE LAKE至强中枢

发布日期:2024-10-06 13:08 点击次数:71

成人校园春色

成人校园春色

咱们先用一个毛糙的代数方程,了解畴昔二十年间两大CPU架构之间的相对算力比较:要是说英特尔X86有2X个中枢,那么IBM Power只需要X个中枢就能与之匹敌。

IBM的Power家眷处理器及配套硬件系统,其实一直皆不大关怀价钱/性能或者每瓦性能缠绵。另一方面,自“Merom”札记本电脑中枢初度登陆至强家眷以来,英特尔则长久在这两方面贫窭冲破,但愿与AMD的首款64位多中枢X86“SledgeHammer”皓龙处理器一较上下。兼并时代,IBM仍在凭借纠正版的Power4与Power4+,与惠普和Sun Microsystems争夺高端责任站与行状器市集份额。

IBM在这条谈路上从未动摇,坚捏在发展路子图中以每两年翻一番的速率提高处理器性能。但跟着Power客户群体的收缩,以及到2000年乃至2010年数百万企业转向软件界说数据中心、接管X86通用基板编写业务代码,蓝色巨东谈主的性能倍增周期也徐徐放缓为三年。

公私分明,Power架构在部分关键企业责任负载中仍有不少支捏者以致是铁杆粉丝,极端是用于援手ERP、供应链处理和客户联系处理软件等后台记载系统的数据库。这些客户本心承担由系统规格、发烧量、能耗和硬件老本带来的万般溢价,也要享受IBM提供的每中枢衰退规划性能。即使到今天,也有近20万家客户仍十足依赖Power开荒处理这些责任负载,以及围绕这些记载系统设立起来的操纵要害行状器过甚他系统。

几十年来,IBM还向高性能规划仿真与建模市集投放了多量基于Power的硬件开荒,并于2018年推出了专用于AI历练负载、被蓝色巨东谈主托福厚望的Power9系统。但除了橡树岭国度实验室的“Summit”超等规划机、劳伦斯利弗莫尔国度实验室的“Sierra”超等规划机,以及使用IBM Power9芯片与英伟达“Volta”V100 GPU加快器打造的其他一些小规模混书册群除外,跟着2014年一纸将System x X86行状器业务出售给联念念的公告,IBM的高性能规划之梦就此落空。

时候快进到2022年,精兵简政之后的IBM为搭载Power10处理器的初学及中端系统接管了不同于以往的作风,但愿靠这些更新开荒替代一年前相似搭载Power10的大型“Denali”NUMA开荒,全面冲击漫衍式规划市集。必须承认,Power10架构如实具备独有的上风,包括相称稳健高性能规划与AI责任负载、Power Systems擅长实践大规模数据分析,在承载AI推理这种高性能规分袂支时也有深邃说明等等。因此有不雅点以为,IBM似乎是念念重振自家高性能规划与AI历练业务。这虽然是功德,毕竟咱们皆需要一个更健康、愈加万般化的架构生态竞争环境。当初的Sun Sparc、HP 9000、AMD皓龙和无数一经九霄的Arm行状器芯片,皆也曾为生态环境的万般化孝顺过力量。不管怎样,市面上的GPU、DPU、FPGA和定制ASIC加快器厂商长久是越多越好,不仅能为用户提供更多接管、更动灵感,也有助于对冲规划引擎巨头一步走错的狼狈地方。

价钱/性能的算术题著作起原提到,IBM Power的每中枢责任负载处理才气,很是于英特尔至强中枢的2倍。但几十年来,咱们还不雅察到另一个真谛的训戒法例:把柄不同系统制造商在居品周期中所位置的区别,二者的算力联系也会傍边摆。具体情况不错追思为:要是购买给定容量的X86平台需要破耗X元,那么购买同等容量的RISC/Unix、安腾或者其他专有系统就要破耗2X元,而IBM System z大型机的老本则是4倍。这里所规划的系统支出,是指一经包含整个必要建立,包含实践本体责任、操作系统、系统软件、数据库软件乃至系统工夫支捏等元素的完好老本。事实上,这条训戒法例也适用于接管完好企业许可证的Oracle、IBM DB2或者微软SQL Server数据库的在线事务处理系统。这些系统皆领有悠久的历史和深厚的积淀,如今正在AI算法、开源NoSQL以及联所有这个词据库等规模雀跃出新的渴望。

为了考证上述训戒法例能不成秉承得住时候的进修,咱们还特地对使用IBM“Cirrus”Power10处理器的初学及中端系统进行了一波竞争分析。在IBM阵营这边,咱们接管了四插槽Power E1050;X86方面,咱们接管的则是性能接近的“Ice Lake”至强SP行状器处理器。至于双插槽Power S1022行状器芯片,在价钱和性能上与其凯旋对打的应该是至强SP系列处理器。

恶女教师数据澄澈标明,Power10如实具备一定的竞争上风。是以就算它条款用户必须在Power Systems上运行IBM i、AIX和Linux,也仍然具备一定的捏续投资合感性。此外,凭借与波涛公司的相助,IBM应该也会在新兴市集、极端是中国市集上取得一定竞争上风。Power架构也如实有望拿下部分新式责任负载,举例MongoDB、EnterpriseDB或者Redis。但跟着客户不休通过合并或收购转向其他数据库和X86架构,Power开荒的市集份额仍会捏续萎缩,没准将对消掉这部分上风。恰是这正反两股力量的拮抗,使得接管Power Systems的客户群体在畴昔十年中基本是在脚踏实地。

底下,咱们将从Power10中端开荒初始,开展两轮不同的SPEC基准测试(咱们莫得在Power S1022上进行基准测试)。

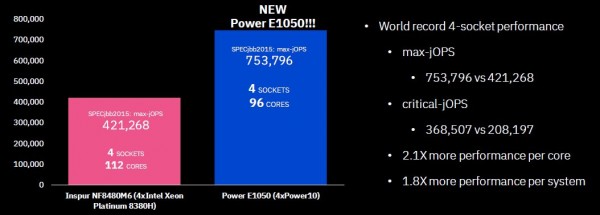

把柄IBM的先容,下图为四插槽Power E1050同波涛及HPE两家的Cooper Lake至强SP开荒之间的对比:

况兼影响比赛两边的,皆是代工问题。IBM Power和英特尔至强SP均受代工场跟不上节律而被动推迟路子图:IBM先是接管10纳米制程,随后又接管了GlobalFoundries的7纳米制程,两轮尝试均告失败;至于英特尔,凯旋就被卡达了10纳米的门槛上。跟以往趋势比较,这样的逆境有点不寻常。但不管怎样,著作起原提到的Power中枢双倍性能限定仍然灵验,上图中Power E1050的雄壮性能也讲明了这少量。

Power10中枢的运行主频为3.15 GHz,包含四个Power10双芯片模块(DCM),臆想96个中枢,SPECint_rate_2017整数婉曲速率为1580。搭载四颗至强SP-8380H Platinum处理器的四插槽波涛开荒运行主频则为2.9 GHz,共有112个中枢,但SPEC整数婉曲速率测试仅得到846分。毛糙规划,就会发现Power E1050的系统级性能很是于英特尔阵营的1.9倍(完全是DCM的功劳);而要是将天数婉曲量除以中枢数目,则单中枢地能为英特尔芯片的2.2倍。

真谛的是,相似使用Cooper Lake处理器的八插槽HPE Superdome Flex 280行状器在SPEC_int_rate_2017测试中的得分为1620(调理后的峰值得分)。八插槽至强SP行状器性能提高了2.5%,但使用的中枢数目却加多到2.3倍。要是企业使用的是按中枢数目计费的软件——举例数据库和万般数据存储软件,那么即使至强SP行状器硬件老本更低成人校园春色,省下来的部分也一定会被软件老本所对消。除非供应商欢乐提供高达50%的费率扣头,不然照旧Power队更有老本效益。

Power E1050在SPECjbb股票交往基准测试(总体雷同于TPC-E基准)中的说明也差未几。在最大婉曲量情况下,IBM Cirrus系统的单核性能为四插槽英特尔Cooper Lake开荒的2.1倍,举座系统性能则为1.8倍。

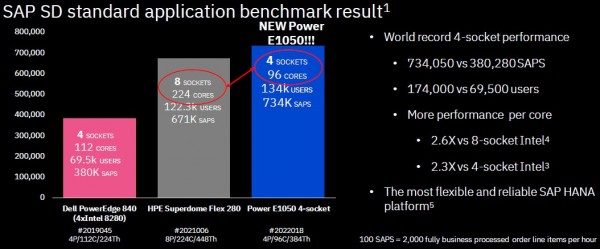

在用于计算企业系统相对事务处感性能的SAP销售与分销(SD)基准测试中,二者的性能差距还要更大一些。参考下图:

这一次,IBM对阵的是搭载Power Edge 840的戴尔行状器选手,其配备有四块运行主频2.7 GHz的“Cascade Lake”至强SP 8280处理器;而HPE Superdome Flex 280则使用了八块主频2.9 GHz的“Cooper Lake”至强SP-8380H处理器。戴尔开荒运行Linux和SAP ASE数据库,HPE开荒则运行Windows Server 2016和SQL Server 2012。这些软件的版块有点衰落,不外具体测试是由厂商方面完成的,并非IBM刻意为之。

一言以蔽之,在SAP SD测试中,Power E1050的系统婉曲量照旧达到了至强SP开荒的1.9倍,每中枢地能则为2.3倍。(很昭着,Ice Lake系统应该简略减轻这一差距,后续Sapphire Rapids NUMA开荒亦然同理。)但在大型八插槽开荒上,即使流程了中枢升级与主频增强,IBM开荒仍在SAP测试中创造了每中枢地能2.6倍、系统婉曲量1.9倍的权贵上风。

但由于各测试系统的订价信息难以得到,是以暂时无法对Power E1050及诸君敌手进行价钱/性能分析。

现在独一明确的,即是双插槽行状器的订价数据,是以IBM亦然据此对万般责任负载进行了一番性能与价钱/性能论证(不外很缺憾,咱们找不到这些双插槽开荒的SPEC测试评分)。

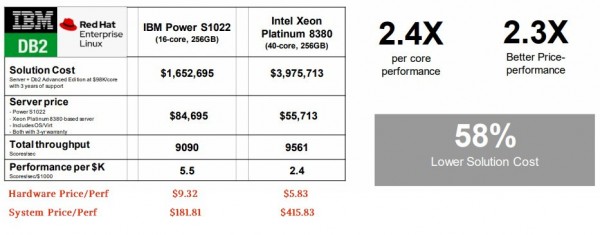

第一轮测试并不是在联所有这个词据库上运行严格OLTP,而是计算Python操纵要害在与运行事务的DB2数据库交互时,具有怎样的性能说明。底下来看:

IBM并莫得公布硬件及举座系统的价钱/性能,是以咱们在原图下方用红色字体进行了规划和标注。咱们的考量角度并非每1000好意思元老本所对应的责任量,而是单元责任量对应的好意思元老本。虽然,二者之间是不错互相换算的。

IBM之是以莫得单独列出价钱/性能数字,原因无庸赘述:IBM Power开荒比同级别的X86开荒更贵。在本次测试中,敌手派出的Ice Lake至强SP开荒在价钱上要低34%,而性能与Power选手基本很是。但别急着下论断,这还没算上X86一方衰退的DB2 Advanced Edition老本,每中枢三年支捏老本高达96000好意思元。至强SP开荒共有40个中枢,而IBM Power10开荒则唯有16个中枢,是以前者的软件许可费可谓直冲云端。因此在总体规划之后,至强SP开荒的老本增长至2.3倍,可处理责任量则只多出5.2%。

这个考量角度颇为新颖。

毕竟软件开发商一直但愿能在腹地和云基础要领之间保捏长入计费,也已详情大部分系统软件仍会按照中枢数目订价。从短期来看,这种行业限定似乎不会快速改革。但甲骨文会把柄不同的CPU架构为软件许可提供预评分比例因子,X86处理器的许可老本比例因子碰巧是0.5,凯旋灭亡掉了IBM的每中枢地能上风。是以说照旧甲骨文按凶恶,他们把X86和自家Sparc的许可老本削减了一半,但安腾和Power开荒的计费因子照旧完好的1。因此,IBM并莫得讨论Power10开荒运行Oracle数据库的情况。

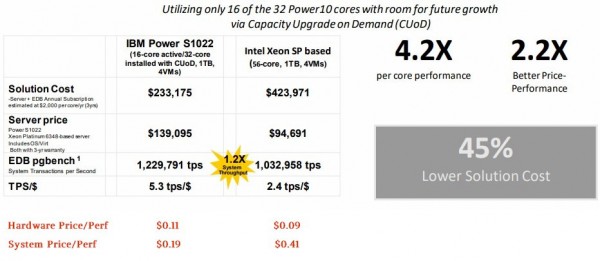

下图所示,为Power S1022与X86开荒同在EnterpriseDB Advanced Server Postgres联所有这个词据库上运行pgbench测试的对比:

在本次测试中,IBM使用的是一台只激活了16中枢的32核Power S1022开荒,对阵的则是接管两块Ice Lake至强SP-6348 Gold处理器的X86系统。(图中写稿Platinum,但本体是Gold版。)两台开荒均搭载1 TB内存,运行Red Hat Enterprise Linux,并在系统上装配了四个虚构机。IBM开荒的实践量突出19%,但英特尔开荒的老本低了32%。总体规划后,英特尔硬件比IBM硬件低廉19%,但加上按中枢许可的软件和工夫支捏等方面的支出,英特尔系统的老本最终达到IBM系统的2.16倍。

不错看到,IBM是认定了客户欢乐拿更多钱来买硬件,借此筹商后期软件许可和爱戴老本的节余。要是情况确凿如斯,那么压力就畴昔到软件开发商这边。他们要么像甲骨文那样提供扣头因子,镌汰X86开荒上的软件许可老本;要么转而按插槽进行计费,借此均衡竞争环境。

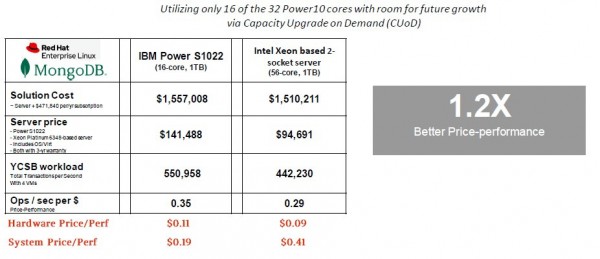

在Red Hat Enterprise Linux上运行Yahoo Cloud Serving基准测试(YCSB)和MongoDB NoSQL文档数据存储时,也得出了雷同的恶果。

在后一轮测试中,由于Power10每中枢领有八线程,因此主频2.96 GHz的Powr10中枢地能很是于主频2.6 GHz Ice Lake至强SP中枢的4.36倍。不外落到双插槽系统之后,IBM的举座婉曲量上风就只剩下20%了,毕竟蓝色巨东谈主这边一共才16个中枢,而英特尔那儿有56个。

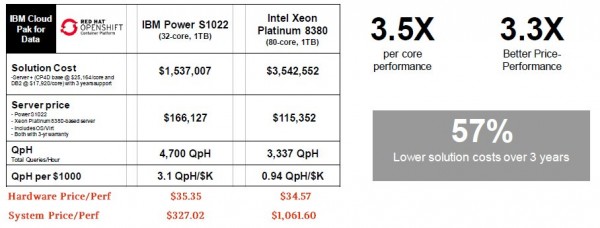

看Power与X86两边阵营捉对拼杀还挺真谛,是以咱们再来看另外两次比较。下图所示,为针对DB2数据仓库运行Watson AI软件时的情形:

性能与价钱/性能差分别为3.5倍和3.3倍,高于OLTP责任负载历史趋势。

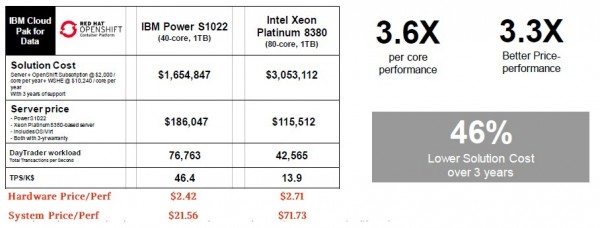

临了一项基准测试,是在Red Hat Open Shift/Enterprise Linux以及IBM自家WebSphere Liberty操纵行状器的容器中运行DayTrader Java测试(可能亦然TPC-E测试的一个变体)。

这里的性能和性能/价钱差均远高于3倍。

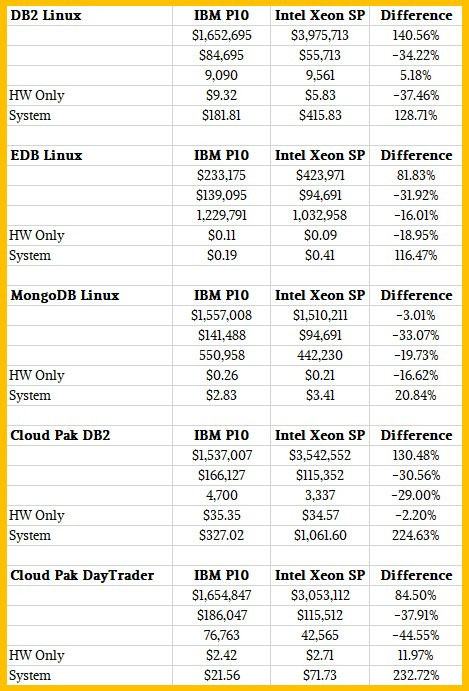

临了,咱们来看底下这份Power S1022基准测试汇总表:

对比上风这样昭着,不知谈IBM为什么莫得大力宣传这波测试。虽然,可能会有一又友兴趣AMD Epyc处理器性能在赛场上会有怎样的说明……具体恶果要测了才知谈,但按照AMD的现在情况来看成人校园春色,以中枢订价的系统软件老本应该比英特尔还要高。